腾讯混元大模型介绍

腾讯混元大模型是由腾讯全链路自研的通用大语言模型,拥有超千亿参数规模,预训练语料超 2 万亿 tokens,具备强大的中文创作能力,复杂语境下的逻辑推理能力,以及可靠的任务执行能力。

值得一提的是,腾讯混元大模型是一个“从实践中来,到实践中去”的实用级大模型。当前,腾讯云、腾讯广告、腾讯游戏、腾讯金融科技、腾讯会议、腾讯文档、微信搜一搜、QQ 浏览器等超过 50 个腾讯业务和产品,已经接入腾讯混元大模型测试,并取得初步效果。

腾讯混元大模型API

- 腾讯混元大模型API控制台

- 腾讯混元大模型API说明文档(3.0)

- 腾讯混元接入小狐狸教程

腾讯混元大模型官网

- 腾讯混元助手官网:https://hunyuan.tencent.com/

- 腾讯混元助手小程序:微信中搜索“腾讯混元助手”或者扫描下方小程序码体验

- 腾讯混元公众号:微信中搜索”腾讯混元”公众号

腾讯将于9月7日正式发布混元大模型,请大家关注2023年腾讯全球数字生态大会。

腾讯全球数字生态大会官网,报名入口网址,腾讯将公布其在人工智能最新进展!

混元AI大模型的特点

全链路自研是腾讯混元大模型的首要特点。腾讯集团副总裁蒋杰介绍,腾讯混元大模型从第一个 token 开始从零训练,掌握了从模型算法到机器学习框架,再到AI基础设施的全链路自研技术。

腾讯在算法层面进行了一系列自研创新,提高了模型可靠性和成熟度。

针对大模型容易“胡言乱语”的问题,腾讯优化了预训练算法及策略,让混元大模型的幻觉相比主流开源大模型降低了 30% 至 50%;通过强化学习的方法,让模型学会识别陷阱问题;通过位置编码优化,提高了超长文的处理效果和性能;提出思维链的新策略,让大模型能够像人一样结合实际的应用场景进行推理和决策。

此外,腾讯还自研了机器学习框架 Angel,使训练速度相比业界主流框架提升 1 倍,推理速度比业界主流框架提升 1.3 倍。

得益于全链路自研技术,腾讯混元大模型能够理解上下文的含义,并且有长文记忆能力,可以流畅地进行专业领域的多轮对话。除此之外,它还能进行文学创作、文本摘要、角色扮演等内容创作,做到充分理解用户意图,并高效、准确地给出有时效性的答复。

腾讯混元大模型架构

据报道,今年5月,腾讯针对ChatGPT对话式产品成立了“混元助手(HunyuanAide)”项目组,由腾讯首席科学家、腾讯AI Lab及Robotics X实验室主任张正友博士负责。

腾讯AI开放平台是一个功能强大、易于使用、价格实惠的人工智能服务平台,适用于各种场景下的AI应用开发和创新。

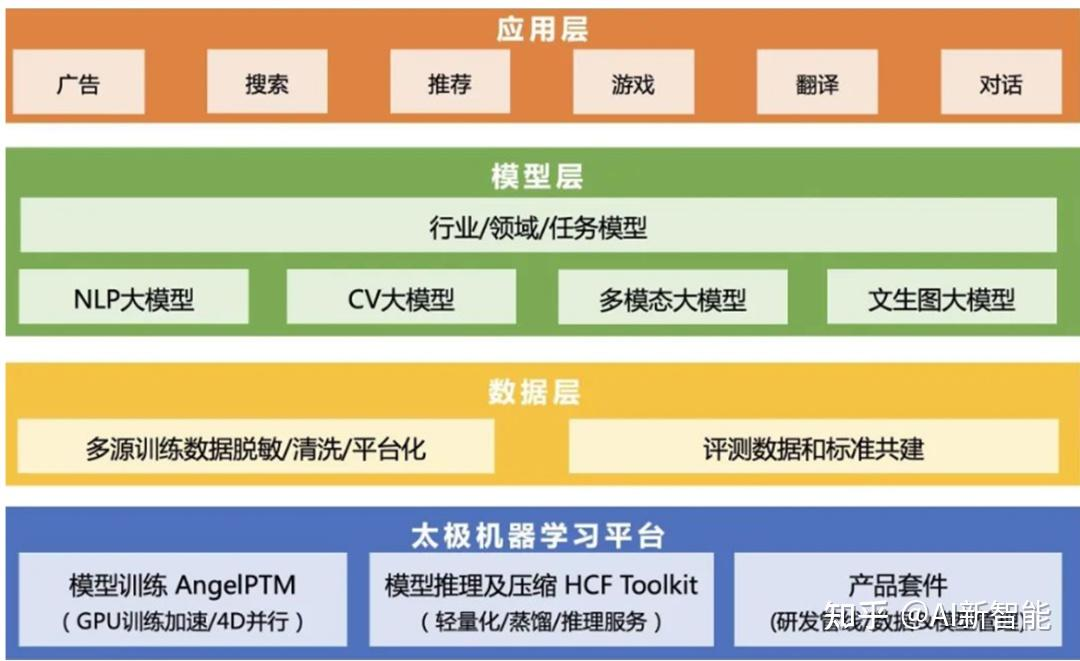

以太极平台的基础,配合强大的底层算力与低成本的高速网络基础设施,腾讯打造了首个可在工业界海量业务场景直接落地,并投入应用的万亿NLP大模型——HunYuan-NLP 1T。混元最快仅用256卡在一天内即可完成万亿参数大模型的训练,整体训练成本仅为直接冷启动训练万亿模型的1/8。

纵观混元在腾讯应用层、模型层的布局,我们可以发现,这样的布局策略,很有可能是想以统一的平台,实现技术复用和业务降本,支持更多的场景和应用。而这样的技术复用和多场景支持,则与腾讯在互联网领域独特的生态位有着密切关系。

混元大模型应用

在2023年腾讯全球数字生态大会上,蒋杰展示了腾讯会议、腾讯文档、腾讯广告等多个业务,在接入腾讯混元大模型后的实际应用情况。

比如腾讯会议基于混元大模型打造了腾讯混元助手,只需要简单的自然语言指令,就能完成会议信息提取、内容分析等复杂任务,会后还能生成智能总结纪要。据实测,在指令理解、会中问答、会议摘要、会议待办项等多个方面,混元大模型均获得较高的用户采纳率。

在文档处理方面,腾讯混元大模型支持数十种文本创作场景,在腾讯文档推出的智能助手功能中已有应用。同时,混元还能够一键生成标准格式文本,精通数百种Excel公式,支持自然语言生成函数,并基于表格内容生成图表,目前这些功能正在内测阶段,将在成熟后面向用户开放。

在广告业务场景,腾讯混元大模型支持智能化的广告素材创作,能够适应行业与地域特色,满足千人千面的需求,实现文字、图片、视频的自然融合。此外,基于混元大模型的能力,广告智能导购能够帮助商家在企业微信等场景,提升服务质量和服务效率。

混元大模型历史消息

3月30日,腾讯集团高级执行副总裁、云与智慧产业事业群CEO汤道生向媒体表示,腾讯正在研发类ChatGPT机器人。

腾讯在大模型领域的布局早已有之,其“混元”系列AI大模型覆盖了NLP、CV、多模态等基础大模型以及众多行业/领域大模型。这成为了腾讯构建类ChatGPT产品的坚实技术储备。

2022年5月,腾讯混元AI大模型在CLUE总排行榜、阅读理解、大规模知识图谱三个榜单同时登顶,一举打破三项纪录。

腾讯混元助手名称变更历史

数据统计

数据评估

关于腾讯混元大模型特别声明

本站智能信息网提供的腾讯混元大模型都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由智能信息网实际控制,在2025年4月26日 下午11:33收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,智能信息网不承担任何责任。

相关导航

Bitscale官网Bitscale是一个强大的AI平台,它

Kling AI

Kling AI, tools for creating imaginative images and videos, based on state-of-art generative AI methods.

豆包大模型

豆包大模型是什么豆包大模型是字节跳动推出的AI大模型家族,包括 豆包PixelDance、豆包Seaweed 视频生成、文生图、图生图、同声传译、角色扮演、语音合成、声音复刻、语音识别、Function Call和向量化等多个模型。豆包大模型具备强大的语言理解、生成和逻辑能力,能进行个性化创作、情绪丰富的语音合成、高精度语音识别、多风格图像生成和顶级的视频生成。豆包大模型通过火山引擎提供服务,支持企业和开发者构建智能化应用,推动AI技术在多种业务场景中的落地。豆包大模型的性能在多个评测中表现优异,例如在包括MMLU、BBH、GSM8K和HumanEval在内的11个业界公认的基准测试集中,Doubao-pro-4k模型的总体得分达到了76.8分,在代码能力、专业知识和指令遵循等方面的显著进步。豆包大模型的主要功能通用模型:字节跳动自研LLM模型,支持128K长文本,全系列可精调,具备更强的理解、生成、逻辑等综合能力,适配问答、总结、创作、分类等丰富场景。视频生成:通过精准语义理解、强大动态及运镜能力创作高质量视频,支持文本和图片生成两种模式。角色扮演:创作个性化角色,具备上下文感知和剧情推动能力,适合虚拟互动和故事创作。语音合成:生成自然生动的语音,能表达多种情绪,适用于文本到语音转换。声音复刻:快速克隆声音,高度还原音色和自然度,支持跨语种迁移,用于个性化语音合成。语音识别:准确识别和转录语音,支持多语种,适用于语音命令和转录服务。文生图:将文本转换为图像,擅长图文匹配和中国文化元素创作,用于图像生成和视觉内容创作。图生图:基于现有图像生成新图像,支持风格变换、扩图、重绘和涂抹等创意操作。同声传译:提供超低延时且自然高质量的实时翻译,支持跨语言同音色翻译,打破沟通中的语言壁垒。Function Call:准确识别和抽取功能参数,适合复杂工具调用和智能交互。向量化:提供向量检索能力,支持LLM知识库的核心理解,适用于多语言处理。豆包大模型的功能特点豆包通用模型Pro:字节跳动自研的高级语言模型,支持128K长文本处理,适用于问答、总结、创作等多种场景。豆包通用模型Lite:轻量级语言模型,提供更低的成本和延迟,适合预算有限的企业使用。豆包·视频生成模型:利用先进的语义理解技术,将文本和图片转化为引人入胜的高质量视频内容。豆包·语言识别模型:具备高准确率和灵敏度,能够快速准确地识别和转写多种语言的语音。豆包·Function Call模型:专为复杂工具调用设计,提供精确的功能识别和参数抽取能力。豆包·文生图模型:将文字描述转化为精美图像,尤其擅长捕捉和表现中国文化元素。豆包·语音合成模型:能够合成自然、生动的语音,表达丰富的情感和场景。豆包·向量化模型:专注于向量检索,为知识库提供核心理解能力,支持多种语言。豆包·声音复刻模型:仅需5秒即可实现声音的1:1克隆,提供高度相似的音色和自然度。豆包·同声传译模型:实现超低延迟的实时翻译,支持跨语言同音色翻译,消除语言障碍。豆包·角色扮演模型:具备个性化角色创作能力,能够根据上下文感知和剧情推动进行灵活的角色扮演。豆包大模型的产品官网产品官网:volcengine.com/product/doubao如何使用豆包大模型确定需求:明确项目或业务需求,比如是否需要文本生成、语音识别、图像创作、视频生成等。选择合适的模型:根据需求选择合适的豆包大模型,例如文生图模型、语音合成、视频生成模型等。注册和访问火山引擎:访问火山引擎官网注册账户,是字节跳动的云服务平台,提供豆包大模型的服务。申请访问权限:在火山引擎平台上申请使用豆包大模型的权限,填写相关信息和使用场景。API接入:获取相应的API接口信息,包括API的端点、请求方法和必要的认证信息。开发和测试:根据API文档开发应用程序,将豆包大模型集成到你的业务流程中。进行充分测试,确保模型的输出符合预期。部署应用:在测试无误后,将集成了豆包大模型的应用部署到生产环境。监控和优化:监控应用的性能和模型的效果,根据反馈进行优化。豆包大模型的产品定价大语言模型按tokens使用量付费:Doubao-lite-4k(包括分支版本lite-character):上下文长度4K、输入0.0003元/千tokens、输出0.0003元/千tokens、后付费、免费额度50万tokens。Doubao-lite-32k:上下文长度32K、输入0.0003元/千tokens、输出0.0006元/千tokens后付费、免费额度50万tokens。Doubao-lite-128k:上下文长度128K、输入0.0008元/千tokens、输出0.0010元/千tokens后付费、免费额度50万tokens。Doubao-pro-4k(包括分支版本pro-character、pro-functioncall):上下文长度4K、输入0.0008元/千tokens、输出0.0020元/千tokens后付费、免费额度50万tokens。Doubao-pro-32k:上下文长度32K、输入0.0008元/千tokens、输出0.0020元/千tokens后付费、免费额度50万tokens。Doubao-pro-128k:上下文长度128K、输入0.0050元/千tokens、输出0.0090元/千tokens后付费、免费额度50万tokens。按模型单元付费:独占的算力资源,更加独立可控Doubao-lite-4k、Doubao-lite-32k:可承载性能(TPS)3000、按小时60元/个、包月28000元/个。Doubao-lite-128k:可承载性能(TPS)4500、按小时240元/个、包月112000元/个。Doubao-pro-4k、Doubao-pro-32k:可承载性能(TPS)3200、按小时160元/个、包月80000元/个。Doubao-pro-128k:可承载性能(TPS)3500、按小时1200元/个、包月550000元/个。视觉模型豆包-文生图模型-智能绘图:推理服务、0.2元/次、后付费、免费额度200次。语音大模型Doubao-语音合成:推理服务、5元/万字符、后付费、免费额度5000字符。Doubao-声音复刻:推理服务、8元/万字符、后付费、免费额度5000字符。向量模型Doubao-embedding:最长输入长度4K、输入0.0005元/千tokens、后付费、免费50万tokens。模型精调按tokens使用量(训练文本*训练迭代次数)计费,训练完成后出账。Doubao-lite-4k、Doubao-lite-32k、Doubao-lite-128k:LoRA定价0.03元/千tokens、后付费。Doubao-pro-4k、Doubao-pro-32k、Doubao-pro-128k:LoRA定价0.05元/千tokens、后付费。更多模型及定价信息,可访问豆包大模型官网获取最新信息。豆包大模型的应用场景内容创作与媒体:使用文生图、图生图、视频生成模型生成文章配图、漫画、海报、短视频等视觉内容。语音合成模型为视频、动画制作配音。客户服务:通过角色扮演模型提供虚拟客服和聊天机器人服务。使用语音识别和语音合成模型改善语音客服系统。教育与培训:文生图模型辅助教学材料的制作,如生成教学插图。角色扮演模型创建个性化学习体验和虚拟教师。娱乐与游戏:在游戏中使用角色扮演模型创建非玩家角色(NPC)的对话和行为。用语音合成模型为游戏角色提供自然的语言交流。智能助手:结合语音识别和语音合成模型,开发智能个人助理。用文生图模型生成个性化的推荐内容。市场与广告:用文生图模型自动生成广告创意和营销素材。用通用模型分析消费者反馈,优化广告文案。企业自动化:通过Function Call模型自动化复杂的工作流程和工具调用。用向量化模型进行高效的信息检索和知识管理。搜索与推荐:用向量化模型改善搜索引擎的准确性和响应速度。结合通用模型为用户推荐相关内容或产品。法律与金融:用通用模型进行合同分析、案件研究和合规检查。用语音识别模型转录会议记录和访谈内容。

Segment Anything(SAM): Meta最新推出的AI图像分割模型

Segment Anything Model(SAM)是Meta AI研究院最新推出的图像分割模型,该模型通过点或框等输入提示生成高质量的物体遮罩,并且可以用于为图像中的所有物体和对象生成遮罩。SAM模型在超过1100万张图像和11亿张掩模的数据集上进行了训练,并且在各种图像分割任务上具有强大的零样本性能。

AiPPT

AiPPT.cn 一键生成PPTAiPPT 利用先进的AI技

腾讯人工智能实验室

研究领域计算机视觉计算机视觉使得计算机能够理解真实的视觉世界

百小应

百小应官网:2024年5月22日,百川智能推出成立之后的首款

智绘设计:腾讯推出的智能设计平台,让内容更精彩

智绘设计是腾讯推出的多场景智能设计平台,提供特有的AI创意创作功能,包括智能人像与商品抠图、风格动漫化、智能消除笔、智能多尺寸、智能配色等。智绘设计的AI特色功能:秒速创作。挑选模板到编辑文案,数秒内可一键出图;百万级优质正版素材、强大出色的在线编辑体验,助你高效创作。智能封面。一键智能生成精美封面,助力新闻资讯、知识文章、短视频、直播、教学课程等内容更吸睛,提升点击转化效果。AI视频剪辑。一键智能生成影片视频,助力电商带货、小说推广、增长投放等场景批量快速生产广告视频素材。智能抠图。一键分离图像画面中的主体内容,可识别人物、动物、商品、动漫角色等,发丝级精细,从此抠图不求人。人像动漫化。一键生成个性化的二次元动漫形象,支持多种漫画风格,可萌可御