Gen-2介绍

Runway最新推出的AI视频生成模型,不用文本,一张图,Gen-2就能生成视频。

好玩到停不下来!

这意味着,一部大片,只需要图片就够了,岂不是人人都能成为好莱坞导演。

这不,已经有网友用Gen-2,结合PS修图,MusicGen、AudioLDM等工具配音,做出了「机器人总动员」翻版影片。

有人把Midjourney和Gen-2混搭,视频画面高级质感简直让人惊掉下巴。

有人用时4小时,制作了一部「火焰之旅」预告片,没有任何提示,只是图像!

有了Gen-2,重拍一部「狮子王」,绝对是不可想象的!

手把手教程

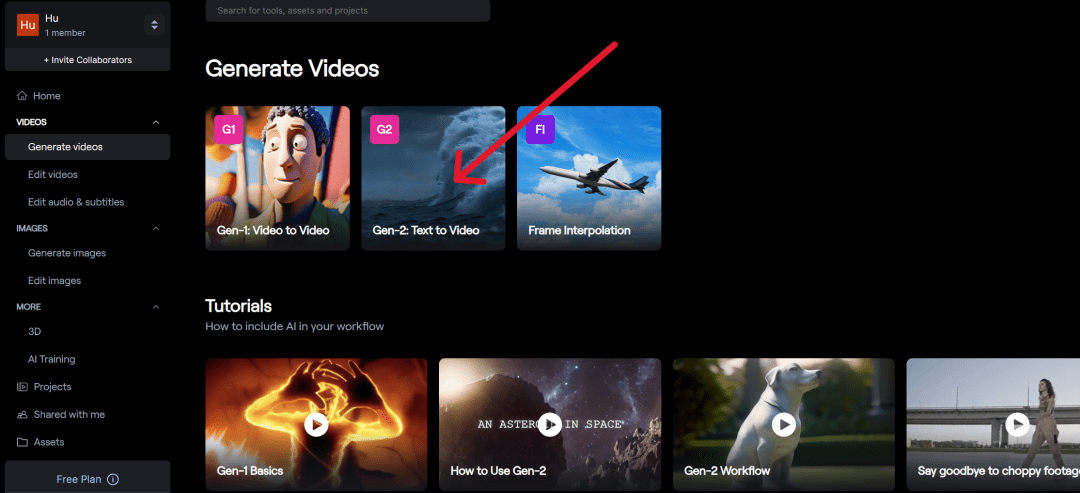

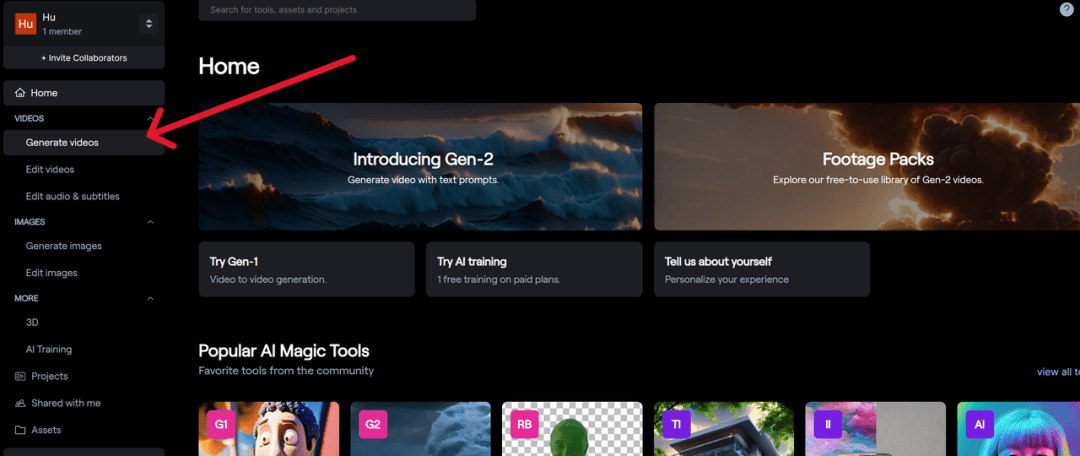

首先通过网页https://research.runwayml.com/gen2注册登录runway的账号,进入runway的编辑界面.

点击左侧的Generate Video。

然后点击屏幕中间的Gen-2:Text to Video进入Gen-2。

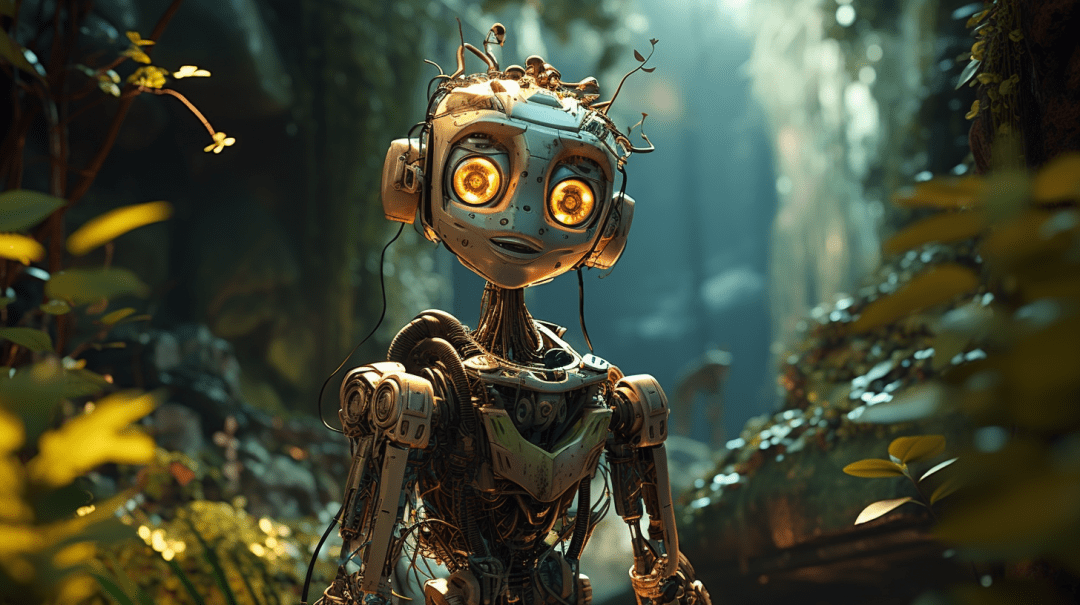

在左边的区域上传一张照片,小编这里用的是一张由Midjourney生成的机器人的照片。

提示词:Futuristic machine who is a kind robot who wants to save his planet from his human friends, cinematic, digital illustration, stylized, deep depth of field, high definition, –ar 16:9 –v 5.2

然后什么Prompt都不用输入,上传完照片之后就直接点击Generate。大概1分钟之后,一段4秒钟的视频就生成了。

图中的机器人瞬间就动了起来!

数据统计

数据评估

关于Gen-2特别声明

本站智能信息网提供的Gen-2都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由智能信息网实际控制,在2025年4月26日 下午10:51收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,智能信息网不承担任何责任。

相关导航

Vizard是什么Vizard是将长视频转换为社交短视频片段的AI视频编辑工具,支持TikTok、Instagram、YouTube Shorts等平台,Vizard服务超200万创作者和团队。Vizard提供团队协作空间,简化项目管理和分享流程。用户上传视频后,AI自动转录、剪辑并生成设计好的视频片段,支持一键下载和分享,操作简便,无需注册即可免费试用。Vizard的主要功能视频转录与剪辑:Vizard自动将用户上传的长视频转录成文字,并根据内容剪辑出关键片段。AI视频生成:基于AI技术为社交媒体平台如TikTok、Instagram、YouTube Shorts生成设计精美的短视频片段。团队协作:提供团队工作空间,允许团队成员进行项目协作、实时预览和与客户或外部团队成员分享。一键分享:用户可以轻松下载、分享视频链接或直接从平台发布视频。如何使用Vizard产品官网:访问 Vizard 的官方网站(vizard.ai)。上传视频:点击上传按钮,选择想要转换的长视频文件进行上传。视频转录:上传后,Vizard 会使用 AI 技术自动转录视频内容,并分析视频中的讲话和场景。选择片段:AI 会根据视频内容生成多个短视频片段。可以浏览这些片段,选择最具吸引力或最符合需求的部分。编辑和定制:可以对生成的片段进行进一步的编辑和定制。生成视频片段:Vizard 根据平台(如 TikTok、Instagram、YouTube Shorts 等)生成最终的视频片段。下载和分享:视频片段生成完成后,可以下载或直接通过链接分享到社交媒体平台。免费试用:Vizard提供免费试用,无需注册即可体验产品功能。Vizard的应用场景社交媒体营销:创作者和品牌可以用Vizard快速制作适合社交媒体的短视频,增加内容的吸引力和传播力。内容创作:视频博主和内容创作者可用Vizard从长视频中提取精彩片段,用于吸引观众或社交媒体上的预告片。企业宣传:企业可以用Vizard将产品介绍、培训材料或公司活动的视频剪辑成短视频,用于内部分享或对外宣传。新闻与媒体:新闻机构可以从采访或报道中提取关键信息,制作成短视频,发布到社交媒体,提高新闻的时效性。

GPT

GPT-4介绍GPT-4(Generative Pre-trained Transformer)是 OpenAI 开发的自然语言处理模型 GPT 家族中的第四个版本,该模型依靠强大的神经网络来理解和生成类似人类的语言。 如何免费使用GPT-4?不开会员的6种方法 目前官方版的GPT-4仅能通过ChatGPT Plus付费会员才能使用,免费版的ChatGPT无法使用最新的GPT-4,而Plus版本需要每个月花费20美元来订阅,并且国内付款非常困... AI教程 2年前 (2023) GPT-4 通过使用被称为「转换器(Transformer)」的特殊架构来帮助软件理解单词的含义以及它们在句子中的组合方式。通俗来讲,Transformer帮助计算机找出如何将所有的词以正确的顺序放在一起,使之有意义。之所以采用这样的方法,是因为该模型已经在一个巨大的数据集上进行了训练,其中包括来自不同来源的文本,如书籍、文章和网站。这种训练使 GPT-4 模型能够进行类似人类的对话,并产生看似有意义的回应。不过虽然 GPT-4 创造的文本和回应读起来像人,但它远远不是有意识的智能,离通用人工智能还有距离。GPT-4的工作原理GPT-4通过与其前身(GPT-3.5)相同的基本流程工作,但规模更大,以下是其主要的工作原理:Transformer架构: GPT-4是使用一种叫做「Transformer」的设计来构建的,这些转换器就像超级智能机器,能够理解一句话中哪些词是重要的,以及它们之间的关系。大规模的预训练: GPT-4从大量的文本中学习,如书籍、网站和文章,这样一来,它就能更好地理解语言模式、语法和事实。微调(Fine-tuning): 在从大量文本中学习后,GPT-4会在特定的任务中接受训练,如回答问题或理解文本中的情感,这有助于它在处理这些任务时变得更加出色。分词(Tokenization): GPT-4将文本分解成更小的部分,称为「tokens」,这些token可以是单词或单词的一部分,这有助于它处理不同的语言并理解词语的含义。上下文窗口(Context window): GPT-4有一个限制,即它可以一次查看多少个token。这个限制有助于它理解语境和单词之间的关系,但这也意味着它不一定能理解很长的句子或段落。概率分布和抽样: 当GPT-4生成文本时,它根据模型认为每个词的可能性的大小来猜测下一个词。然后,它从这些猜测中挑选出一个词,使其够创造出多样化和有趣的句子。细粒度控制(Fine-grained control): GPT-4可以通过使用特殊提示或调整其设置等技巧,引导它给出特定类型的答案或文本,以帮助从该模型中获得我们想要的结果。ChatGPT和GPT-4的区别ChatGPT 和 GPT-4 并不是同一回事,ChatGPT 是基于 GPT-3.5 和 GPT-4 模型的,专门为对话式人工智能应用而设计的,比如根据用户输入生成类似人类的文本回复。而GPT-4指的是GPT系列大语言模型的当前版本——驱动ChatGPT的引擎。ChatGPT提供的输出读起来更自然,GPT-4更强大,在输入/输出方面可以处理更多文本。GPT-4可以免费访问吗?这个问题的答案:是也不是。用户可以通过ChatGPT、New Bing等软件访问GPT-4,这些平台使用GPT-4来生成内容并与用户互动。然而,GPT-4只有在ChatGPT Plus付费计划下才能使用,或者作为开发者建立应用程序和服务的API。New Bing(新必应)可以每天免费有限次数使用GPT-4驱动的AI聊天,而独立用户在这些人工智能聊天机器人平台之外没有机会使用GPT-4。

BLOOM

HuggingFace推出的大型语言模型(LLM)

Gradio

Gradio是一个开源的Python库,用于构建演示机器学习或数据科学,以及web应用程序。你可以使用Gradio基于自己的机器学习模型或数据科学工作流快速创建一个漂亮的用户界面,让用户可以尝试拖放他们自己的图像、输入文本、录制他们自己的声音,并通过浏览器与你的演示程序进行交互。Google、HuggingFace、亚马逊、Meta、思科、VMware等公司都在使用。Gradio适用于:向客户/合伙人/用户/学生演示您的机器学习模型。通过自动共享链接快速部署您的模型,并获得模型性能反馈。在开发过程中使用内置的操作和解释工具交互式地调试模型。

文心大模型

百度推出的产业级知识增强大模型

海螺AI – 你的AI智能助手

海螺AI官网MiniMax不声不响出了款让人惊喜的生产力产品

通义千问

通义千问官网通义千问是基于的大语言模型的产品,它利用自然语言

即梦AI

即梦AI是什么即梦AI是字节跳动推出的一站式AI创作平台,支持AI视频生成和AI图片生成。用户可通过自然语言或图片输入生成高质量的图像和视频。即梦AI提供AI绘画、智能画布、视频生成以及故事创作等多种功能,降低创作门槛,激发用户创意。用户可以用即梦AI的AI视频生成功能,输入简单的文案或图片,快速生成视频片段,且视频动效效果连贯性强、流畅自然。即梦AI还提供中文创作支持,根据中文提示词进行创作,拥有更好的语义理解能力。即梦平台还设有创意社区,用户可以在这里与其他创作者交流灵感,共同探索创意。即梦AI的会员服务允许用户通过购买积分来生成更多的图片或视频内容。即梦AI的主要功能AI图片创作:即梦AI支持文生图和以图生图两种方式,用户输入关键词或描述,AI能迅速生成相应的图片,支持超现实场景、人物肖像等多样风格。用户上传一张图也能生成具有不同风格的新图片。AI视频创作:提供从剧本构思到视频成片的一站式服务,用户只需输入故事梗概或关键描述,AI能自动生成连贯、视觉冲击力强的视频内容。AI图片编辑:用户可以对现有图片进行创意改造,如背景替换、风格转换、人物姿势保持等。智能画布:集成AI拼图生成能力,支持局部重绘、一键扩图、AI消除去水印和AI抠图等多功能操作。对口型:即梦AI的“对口型”是视频生成中的二次编辑功能,支持中文、英文配音,主要针对写实/偏真实风格化人物的口型及配音生成,为用户的创作提供更多视听信息传达的能力 。多语言支持:特别优化对中文的理解,更好地满足中文用户的需求。社区互动:用户可以浏览、评论其他用户的作品,参与创意挑战赛,构建开放、多元的创意社区。会员服务:提供不同级别的会员订阅,包括积分生成、视频延长、去水印等特权服务。即梦AI的项目地址产品官网:jimeng.jianying.com即梦AI APP下载链接:https://agixxw.com/app/15155.html如何使用即梦AI注册/登录:访问产品官网注册新账户或账户登录。选择功能:登录后,可以根据需要选择不同的创作功能,如AI图片创作、视频创作等。输入描述:在图片或视频创作模块中,输入想要生成内容的描述或关键词。描述可以是场景、人物、动作等。调整参数:根据需要调整生成内容的参数,如风格、色彩、画面比例等。生成内容:点击生成按钮,AI将根据描述和参数设置生成图片或视频。编辑和优化:生成的图片或视频需要进一步编辑和优化以满足要求。用即梦AI的编辑工具进行调整。即梦AI的产品定价即梦AI的产品定价策略包括免费版和付费会员制。免费版用户每天可以获得60-100积分,积分可用于生成图片和视频(积分不够用?多注册几个账号~)。平台还提供了多种付费订阅选项:基础会员:价格为79元/月,提供更多的积分以生成更多的图片和视频。标准会员:价格为239元/月,相较于基础会员,提供更多的积分和其他特权。高级会员:价格为649元/月,是最全面的订阅选项,提供更多的积分和其他高级功能。即梦AI的适用人群创意爱好者:对艺术创作有热情,喜欢尝试新工具和技术来表达自己的创意。设计师:需要快速生成设计概念或视觉元素的平面设计师、UI/UX设计师等。内容创作者:包括博主、视频制作者、社交媒体影响者等,需要制作吸引人的视觉内容。广告和营销专业人士:需要为广告活动或营销材料快速制作吸引人的视觉和视频内容。教育工作者:用AI创作工具激发学生创造力,或在教学中使用视觉辅助材料。

暂无评论...